|

شبكة عصبونية اصطناعيةشبكة عصبونية اصطناعية

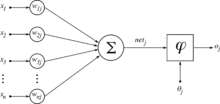

الشبكات العصبونية الاصطناعية (بالإنجليزية: Artificial Neural Network ANN) أو ما يدعى أيضا بالشبكات العصبونية المحاكية simulated neural network أو SNN : مجموعة مترابطة من عصبونات افتراضية تنشئها برامجٌ حاسوبيَّةُ لتشابه عمل العصبون البيولوجي أو بنى إلكترونية (شيبات إلكترونية مصممة لمحاكاة عمل العصبونات) تستخدم النموذج الرياضي لمعالجة المعلومات بناء على الطريقة الاتصالية في الحوسبة.[2][3][4] تتألف الشبكات العصبونية بشكل عام عناصر معالجة بسيطة تقوم بعمل بسيط لكن السلوك الكلي للشبكة يتحدد من خلال الاتصالات بين مختلف هذه العناصر التي تدعى هنا بالعصبونات ومؤشرات هذه العناصر element parameters. الإيحاء الأول بفكرة الشبكات العصبونية أتى من آلية عمل العصبونات الدماغية التي يمكن تشبيهها بشبكات بيولوجية كهربائية لمعالجة المعلومات الواردة إلى الدماغ. في هذه الشبكات اقترح دونالد هب أن المشبك العصبي يلعب دورا أساسيا في توجيه عملية المعالجة وهذا ما دفع للتفكير في فكرة الاتصالية والشبكات العصبونية الاصطناعية. تتالف الشبكات العصبونية الاصطناعية من عقد أو ما قد ذكرنا مسبقا انه عصبونات neurons أو وحدات معالجة processing elements، متصلة معا لتشكل شبكة من العقد، وكل اتصال بين هذه العقد يملك مجموعة من القيم تدعى الأوزان تسهم في تحديد القيم الناتجة عن كل عنصر معالجة بناء على القيم الداخلة لهذا العنصر. مقدمةيمكننا تعريف الشبكات العصبية بأنها محاولة رياضية برمجية لمحاكاة طريقة عمل المخ البشري. حيث أن العلماء قد اكتشفوا تقريبا طريقة عمل المخ البشري من حيث قابلية التعلم وقابلية التذكر والقدرة على تمييز الأشياء والقدرة على اتخاذ القرارات. والمخ كما تعلمون يتكون من مليارات الخلايا العصبية المتشابكة فيما بينها بطريقة معقدة جدا عن طريق الزوائد العصبية لكل خلية، مما يشكل شبكة هائلة من الخلايا العصبية المرتبطة فيما بينها عن طريق هذه الزوائد. هذه الترابط فيما بين الخلايا العصبية يتيح لها القدرة على تخزين المعلومات والصور والصوت وخلافه من الإشارات التي تصلها عبر الحواس الخمسة، ومن ثم تتيح لها أيضا التعلم عن طريق التكرار والخطأ. فمثلا لو أتينا بطفل صغير وعرضنا عليه مجموعة من صور الحيوانات المختلفة فيها مثلا فيل وزرافة وببغاء؛ تعلم الآن الطفل الصغير هذه الحيوانات وأسمائها. لو عرضنا عليه الآن صورة لطير لم يره من قبل ولنفرض أنه الكناري وقلنا له ما هذا الحيوان فإنه بناء على تعلمه سابقا فإنه سيقول أنه ليس فيلا وليس زرافة ولكنه يشبه إلى حد كبير الببغاء. سنقول له صحيح، هذا يشبه الببغاء ولكنه ليس ببغاء وإنما هو كناري. الآن ما الذي حصل؟ لقد استطاع هذا الطفل الصغير التعلم بناء على النماذج الثلاثة الأولية التي تدرب عليها، استطاع أيضا اتخاذ قرار صحيح مع الطير الجديد. أخيرا تدرب على الكناري بحيث أنه في المرات القادمة سوف يستطيع أن يفرق بين الببغاء والكناري مع التشابه بينهما. كل ما سبق حصل مع هذا الطفل الصغير لأن الدماغ البشري يعمل بطريقة تؤهله للتعلم والتذكر واتخاذ القرارات عندما يحتاج لذلك، وذلك بسبب تركيبة الدماغ التي تكلمنا عليها سابقا. عندما اكتشف العلماء طريقة عمل الدماغ حاول العلماء الرياضيون أن يحاكوا طريقة عمل الدماغ بواسطة نماذج رياضية. نشأ عن هذا العلم الجديد ما يسمى بالذكاء الصناعي وأحد أنواع هذا الذكاء الصناعي هو الشبكات العصبية والذي هو أساس موضوعنا الآن. رأينا سابقا أن الطفل الصغير خصص جزءا من خلايا دماغه لتكوين شبكة عصبية تعلم بها التمييز بين الصور التي عرضت عليه. وأن هذه الشبكة يمكن أن تتطور وتتعلم وتنمو أكثر فأكثر وتصبح قادرة أكثر على اتخاذ القرارات الصحيحة. وهكذا فإن أي شيء يتعلمه الطفل يتم تخصيص شبكة عصبية خاصة بهذا العلم؛ ولكن بكثير من التعقيد والربط المعقد بين هذه الشبكات المختلفة.الآن نأتي لأبسط شكل لهذه الشبكات العصبية والذي قام علماء الرياضيات بمحاكاته برمجيا وصنع نموذج رياضي له. يتكون هذا النموذج الرياضي من خلايا عصبية اصطناعية. تتكون كل خلية عصبية اصطناعية من ثلاثة أقسام رئيسية هي: - الوزن: وهو وزن أو عامل تثقيل لكل خلية عصبية اصطناعية وهو عبارة عن رقم مجرد. - الجامع: وهو عبارة عن حاصل جمع وزن كل خلية مضروبة بالدخل. - تابع التفعيل: وهو عبارة عن علاقة أسية لمعالجة إشارة الخرج بحيث تمر هذه الإشارة من خلال هذا التابع ومنه تنتج القيمة النهائية المطلوبة. يكمن أحد أسباب تفوق الدماغ البشري في قدرته على معالجة المعطيات في شكل هيكلي بمعني ان كل جزء من المخ له وظيفه ويشرف علي عمله جزء آخر يدير عمله ويستطيع أن يغير عمل الأجزاء ويسمي ذلك Plasticity كما أن كل جزء من المخ يعمل بصفه منفصله عن الآخر كما لو كان جهازاً حاسوبياً به عدد كبير جدا من المعالجات (Processors)، أجهزة الحاسوبِ اليوم تقوم بمحاكاة هذه العملية في ما يسمى حوسبة متوازية، Parallel Computing، وبالرغم من السرعة العالية الناتجة عن هذه التقنية إلا أنها تفتقر إلى القدرة على الاستقلال بحل المشكلة، وذلك لان الحاسب الإلكتروني يقوم بارسال بيانات كثيرة جدا في صورة رقمية بين كل من أجزائه أما المخ فيقوم بعمل ذلك في صورة رقميه في بعض الأماكن وفي أماكن أخرى في صورة أنالوج كما أن الحَاسُوبَ يرسل عددًا كبيرًا من البيانات المتكررة ولكن المخ لايرسل بيانات متكررة ومثال علي ذلك الكاميرا فهي ترسل حالة كل نقطة تصورها وإذا لم تتغير الحالة ترسلها كما هي أيضا أما العقل فيرسل التغيير فقط وذلك على شكل Spikes أو إشارات عصبية. دونالد هيب،Hebb في كتابه منظمة السلوك 1949م، أشار إلى أنّ المشابك العصبية الروابط (العصبونات) بين الخلايا العصبية تقوى كلما تم استعمالها أكثر بمعني أنه لو وجد عدد من الخلايا بجانب بعضها ولكن اثنان منهم يقومان بنقل بينات بصورة كثيفة فتقوى الوصلة بينهما وتصبح عملية معالجتها للعمليات أسرع مع تكرار إثارتها بنفس المعطيات. كانت هذه بداية التفكير لما يسمى بالمعالجات العصبية أو الشبكات العصبية والتي كانت مطروحة في وقتها على صورة خلايا وليس شبكات مترابطة. في الخمسينات من القرن العشرين قامت شركة أي بي إم بأول محاولة لمحاكاة الخلية العصبية، ونجح ذلك بعد عدة محاولات فاشلة، ولكن كان علم الحَاسُوبِ في ذلك الوقت يتجه ناحية الحساب المتسلسل مما أدى إلى إهمال موضوع الخلايا العصبية ووضعه في الأدراج. في نهاية الخمسينيات، بدأ فرانك روزنبلات بالعمل على ما يدعى اليوم بالبيرسيبترون، Perceptron، حيث كان قادرًا على فصل النقاط القابلة للفصل خطيّا دون النقاط غير القابلة للفصل خطيًّا. وهذا ما اعتبر عيبًا ضخمًا في البيرسبترون. في عام 1959م قام برنارد فيدرو وماركيان هووف ببناء نموذجي عنصر تكيفي خطي آدالاين ADAptive LINear Element ومجموعة عناصر تكيفية خطية مادالاين Many ADALINE. كان هذا هو أول ظهور للشبكات العصبية بشكلها الحالي. كانت تستخدم كفلاتر أو مرشحات قابلة للتكيف (Adaptive Filter) لإلغاء الصدى من خطوط الهاتف. وما تزال تستعمل تجاريًّا حتى هذا الوقت. تاريخالأعمال المبكرةتستند الشبكات العصبية العميقة المعاصرة إلى أسس إحصائية عريقة تعود إلى ما يزيد على قرنين من الزمان.[5] أبسط نماذج الشبكات العصبية ذات التغذية الأمامية هي الشبكات الخطية التي تتألف من طبقة واحدة من العُقد العصبية ذات دوال تنشيط خطية.[6] وفيها تتدفق المدخلات مباشرة إلى المخرجات عبر مجموعة من الأوزان.[7] يُحسب مجموع حاصل ضرب الأوزان بالمدخلات في كل عقدة. ويتم تقليل متوسط مربعات الأخطاء بين هذه المخرجات المحسوبة والقيم المستهدفة المعطاة من خلال إجراء تعديلات على الأوزان.[8] تُعرف هذه التقنية منذ أكثر من قرنين باسم طريقة المربعات الدنيا أو الانحدار الخطي. وقد استُخدمت كأداة لإيجاد أفضل ملاءمة خطية لمجموعة من النقاط من قبل ليجاندر (1805) وغاوس (1795) للتنبؤ بحركة الكواكب.[9] تاريخيًا، تعمل الحواسيب الرقمية، على غرار معمارية فون نيومان، على تنفيذ سلسلة متعاقبة من الأوامر الصريحة مع الوصول إلى الذاكرة عبر مجموعة من المعالجات. وفي المقابل، نشأت بعض الشبكات العصبونية من محاولات محاكاة معالجة المعلومات في الأنظمة الحيوية عبر إطار الاتصال. وخلافًا لنموذج فون نيومان، لا تفصل الحوسبة الاتصالية بين الذاكرة والمعالجة. درس وارن مكولوخ ووالتر بيتس نموذجًا حاسوبيًا للشبكات العصبية لا يعتمد على التعلم.[10][11] وقد مهد هذا النموذج السبيل لانقسام البحث في هذا المجال إلى اتجاهين رئيسيين: الأول يركز على العمليات البيولوجية، والثاني يركز على تطبيق الشبكات العصبية في مجال الذكاء الاصطناعي. وفي أواخر الأربعينيات من القرن الماضي، اقترح الدكتور دونالد أولدينغ هيب فرضية تعليمية تستند إلى آلية اللدونة العصبية، عُرفت بنظرية هيب.[12] وقد استُخدم هذا المفهوم في العديد من الشبكات العصبية الأولى، مثل بيرسيبترون الذي ابتكره روزنبلات وشبكة هوبفيلد. واستخدم فارلي وكلارك الحواسيب لمحاكاة شبكة هيب.[13] كما أنشأ "روتشستر"، و"هولاند"، و"هابيت"، و"دودا" آلات حوسبة أخرى للشبكات العصبية.[14] في 1958 وصف العالم النفسي فرانك روزنبلات البيرسيبترون، [15] كأحد أوائل الشبكات العصبية الاصطناعية التي طُبِّقت عمليًا، [16][17] بدعم من مكتب أبحاث البحرية الأمريكي.[18][19] وقد أشار "آر دي جوزيف" (1960) إلى جهاز سابق شبيه بالبيرسيبترون لفارلي وكلارك، قائلًا: "سبق فارلي وكلارك من مختبر لينكولن بمعهد ماساتشوستس للتكنولوجيا بالفعل روزنبلات في تطوير جهاز يشبه البيرسيبترون".[8][20] ومع ذلك، "تخلَّيا عن الموضوع". وقد أثار البيرسيبترون حماسًا عامًا بشأن البحث في الشبكات العصبية الاصطناعية، مما دفع الحكومة الأمريكية إلى زيادة تمويلها. وساهم ذلك في "العصر الذهبي للذكاء الاصطناعي" الذي تغذَّى بالادعاءات المتفائلة التي أطلقها علماء الحاسوب بشأن قدرة البيرسيبترون على محاكاة الذكاء البشري.[21] لم تكن الشبكات العصبية الاصطناعية من نوع البيرسيبترونات في بداياتها مزودة بوحدات خفية قابلة للتكيّف. ومع ذلك، فقد أطلق جوزيف (1960) فكرة البيرسيبترونات متعددة الطبقات والتي تضم طبقة خفية قابلة للتكيّف.[20] وقد استشهد روزنبلات (1962) بهذه الأفكار واعتمد عليها، [22] كما أثنى على إسهامات "إتش دي بلوك"، و"بي دبليو نايت". غير أن هذه المساعي المبكرة لم تسفر عن تطوير خوارزمية تعليم فاعلة للوحدات الخفية، وهو ما يُعرف اليوم بالتعليم العميق. الانفراجات الكبرى في التعلم العميق خلال الستينيات والسبعينياتأُجريت خلال الستينيات والسبعينيات من القرن العشرين أبحاث أساسية في مجال الشبكات العصبية الاصطناعية. وكانت أول خوارزمية فعالة للتعلم العميق هي طريقة المجموعة لمعالجة البيانات، وهي طريقة لتدريب الشبكات العصبية العميقة بشكل عشوائي، وقد نشرها أليكسي إيفاخنكو ولابا في أوكرانيا عام 1965. اعتبرها الباحثان نوعًا من الانحدار متعدد الحدود،[23] أو تعميمًا لبيرسيبترون روزنب لات.[24] وقد وصفت ورقة بحثية عام 1971 شبكة عميقة مكونة من ثماني طبقات، تم تدريبها باستخدام هذه الطريقة، [25] والتي تستند إلى التدريب طبقة تلو طبقة من خلال تحليل الانحدار. ويتم تقليم الوحدات الخفية الزائدة باستخدام مجموعة تحقق منفصلة. وبما أن دوال التنشيط للعُقد هي كثيرات حدود كولموغوروف-جابور، فإن هذه كانت أيضًا أول الشبكات العميقة بوحدات ضربية أو "بوابات".[8] نُشر أول بيرسيبترون متعدد الطبقات للتعلم العميق مدرب بتقنية التدرج العشوائي عام 1967 على يد العالم شونييتشي أماري.[26][27] وفي تجارب حاسوبية أجراها طالب أماري، وهو سايتو، تمكنت الشبكة العصبية ذو المستقبلات متعددة الطبقات (MLP) والتي تتكون من خمس طبقات، اثنتان منها قابلتان للتعديل، من تعلم تمثيلات داخلية لتصنيف فئات أنماط غير خطية قابلة للفصل.[8] وقد أدت التطورات المتلاحقة في الأجهزة وضبط المعلمات الفائقة إلى جعل تقنية النزول التدرجي العشوائي الشامل هي التقنية السائدة حاليًا في تدريب هذه الشبكات. في عام 1969، قدم كوني هيكو فوكوشما دالة التنشيط الخطي المصحح.[8][28][29] أصبح المُصحح دالة التنشيط الأكثر شيوعًا للتعلم العميق.[30] ومع ذلك، توقف البحث في الولايات المتحدة بعد عمل مينسكي وبايبرت في العام ذاته، [31] اللذان أكدا أن البيرسيبترونات الأساسية غير قادرة على معالجة بوابة الفصل الإقصائي. وقد كانت هذه الرؤية غير ذات صلة بالشبكات العميقة لإيفاخنكو (1965) وأماري (1967). في عام 1976 قُدم التعلم الانتقالي في تعلم الشبكات العصبونية.[32][33] قدِمَتْ الأسس الأولى لِبناء الشبكات العصبونية الالتفافية (CNNs) في مجال التعلم العميق عبر إدراج طبقات الالتفاف وتقليص الحجم ونسخ الأوزان، وذلك بفضل النموذج النيوكونييترون الذي طرحه كوني هيكو فوكوشيما عام 1979، رغم عدم تدريبه باستخدام خوارزمية الانتشار العكسي.[34][35][36] الانتشار العكسييُعد الانتشار العكسي تطبيقًا عمليًا لقاعدة السلسلة التفاضلية التي وضعها غوتفريد لايبنتس عام 1673، [37] وذلك في سياق الشبكات العصبية الاصطناعية. ورغم ظهور مصطلح مصطلح "أخطاء الانتشار العكسي" عام 1962 على يد "روزنب لات"، [22] إلا أنه لم يتمكن من تحديد آلية تنفيذه. بيد أن "هنري جي كيلي" كان قد توصل إلى فكرة مشابهة للانتشار العكسي عام 1960 في سياق نظرية التحكم.[38] في عام 1970 قدم "سيبو ليناينما" الشكل الحديث للانتشار العكسي في أطروحته للماجستير، [8][39][40] وأعاد "جي إم أستروفسكي" وآخرون نشره عام 1971.[41][42] وفي عام 1982 طبق "بول ويربوس" الانتشار العكسي على الشبكات العصبية، [43][44] رغم أن أطروحته للدكتوراه عام 1974، التي أعيد نشرها كتابًا عام 1994، [45] لم تتضمن وصفًا تفصيليًا للخوارزمية.[42] وفي عام 1986 عمم "ديفيد إي روميلهارت" وآخرون الانتشار العكسي دون الإشارة إلى الأعمال السابقة.[46] الشبكات العصبية التلافيفيةقدَّمَتْ شبكة كونييهيكو فوكوشيما العصبية التلافيفية (CNN) في عام 1979 مفهوم التجميع الأعظمي، وهو إجراء تقليص شائع في بنية هذه الشبكات.[34] وقد أصبحت هذه الشبكات فيما بعد أداةً أساسيةً في مجال الرؤية الحاسوبية.[47] وفي سياقٍ آخر، استخدمت الشبكة العصبية للتأخير الزمني (TDNN) التي طرحها ألكسندر وايبل عام 1987 التلافيف ومشاركة الأوزان والانتشار العكسي لتطبيق مبادئ الشبكات التلافيفية على التعرف على الأصوات اللغوية.[48][49] كما طبق "وي زانغ" في العام نفسه شبكة تلافيفية مُدرَّبة بالانتشار العكسي للتعرف على الأبجدية.[50] وفي عام 1989 طوَّر يان ليكون وزملاؤه شبكة عصبية التفافية تُعرف باسم "لي نت" خصيصًا للتعرف على رموز البريد البريدي المكتوبة بخط اليد.[51] وتلا ذلك في العام التالي تطبيق "وي زانغ" لشبكة عصبية التفافية على أجهزة الحوسبة البصرية.[52] وشهد عام 1991 تطبيقًا واسعًا للشبكات العصبية التلافيفية في مجال الطب، حيث استخدمت في تجزئة الأجسام في الصور الطبية، [53] وكشف سرطان الثدي في صور الثدي الشعاعية.[54] وفي عام 1998 قدم يان ليكون وزملاؤه شبكة "لي نت 5" ذات السبعة مستويات، والتي حققت نجاحًا كبيرًا في تصنيف الأرقام المكتوبة بخط اليد، مما أدى إلى اعتمادها من قبل العديد من البنوك للتعرف على الأرقام على الشيكات الرقمية.[55] منذ عام 1988 فصاعدًا، شهد مجال توقع بنية البروتين تطورات ملحوظة بفضل استخدام الشبكات العصبية.[56][57] ولا سيما عندما دُربت أولى الشبكات المتسلسلة على الملفات الشخصية (المصفوفات) الناتجة عن محاذاة تسلسلات متعددة.[58] الشبكات العصبية المتكررةكانت الميكانيكا الإحصائية من أصول الشبكات العصبية الدورية الأساسية. ففي عام 1972 اقترح شونييتشي أماري تعديل أوزان نموذج إيزينج بقاعدة التعلم العصبونية ليصبح نموذجًا للذاكرة الترابطية، مُضيفًا بذلك عنصر التعلم.[59] وقد اشتهر هذا النموذج باسم شبكة هوبفيلد بعد أن تطرق إليه جون هوبفيلد عام 1982.[60] كما كان لعلم الأعصاب دور أساسي في نشأة الشبكات العصبية الدورية. فكلمة "دورية" هنا تستمد معناها من الهياكل الحلقية الموجودة في التشريح العصبي. فقد لاحظ كاخال عام 1901 وجود "دوائر نصف دائرية دورية" في قشرة المخيخ.[61] واعتبر هيب أن "الدائرة المرتدة" هي تفسير محتمل للذاكرة قصيرة المدى.[62] كذلك، فقد أشار مقال ماكولوخ وبيتس (1943) إلى أن الشبكات العصبية التي تحتوي على دورات يمكن أن تتأثر أنشطتها الحالية بأنشطتها السابقة إلى أجل غير مسمى.[10] برزت "المصفوفة التكيفية المتقاطعة" في 1982 وهي عبارة عن شبكة عصبية تكرارية، ذات بنية مصفوفة بدلًا من البنية المتعددة الطبقات.[63][64] اعتمدت هذه الشبكة على اتصالات تكرارية مباشرة من المخرجات إلى مدخلات المراقب (التدريب). ولم تقتصر مهمتها على حساب الأفعال (القرارات) فحسب، بل امتدت لتقدير حالات داخلية (عواطف) للمواقف الناتجة. وبإلغاء المراقب الخارجي، أضفت هذه الشبكة خاصية التعلم الذاتي إلى عالم الشبكات العصبية. شهد مجال علم النفس الإدراكي في مطلع الثمانينات نقاشًا علميًا عميقًا حول العلاقة التفاعلية بين الإدراك والعاطفة. وقد برز هذا النقاش جليًا في مجلة "العالم النفسي الأمريكي"، حيث طرح زاجونت عام 1980 فرضية أن العاطفة تسبق الإدراك وتحدث بشكل مستقل عنها. وفي المقابل، ذهب لازاروس في نفس العام إلى أن الإدراك هو المحرك الأول للعاطفة ولا يمكن فصله عنها.[65][66] وقد قدم الباحثون في ذلك العام نموذجًا جديدًا أسموه "المصفوفة التكيفية المتقاطعة"، وهو نموذج شبكي يهدف إلى توضيح هذه العلاقة المعقدة بين المتغيرين. يُعد هذا النموذج مثالًا حيًا على التكامل بين العلوم المعرفية والذكاء الاصطناعي، حيث استخدمت الشبكات العصبية التكرارية كأداة لتحاكي هذه العلاقة.[63][67] كان من أوائل الأعمال المؤثرة في هذا المجال شبكة جوردن (1986) وشبكة إلمان (1990)، اللتان طبقتا الشبكات العصبونية المتكررة لدراسة علم النفس المعرفي. في الثمانينيات لم تكن خوارزمية الانتشار العكسي تؤتي ثمارها على النحو الأمثل مع الشبكات العصبونية المتكررة العميقة. ولتجاوز هذه المعضلة، اقترح يورغن شميدهوبر عام 1991 ما يُسمى "المجزئ التسلسلي العصبي" أو "ضاغط التاريخ العصبي"، [68][69] والذي قدم مفاهيم أساسية مثل التدريب الذاتي المسبق (الـ "P" في نموذج ChatGPT) وتقطير المعرفة العصبية.[8] وفي عام 1993 تمكن نظام ضاغط التاريخ العصبي من حل مسألة "التعلم العميق جدًّا" التي تتطلب أكثر من ألف طبقة متتالية في شبكة عصبونية متكررة ذات بنية زمنية.[70] في 1991 حدد "سيب هوخريتر" في رسالته للدراسات العليا مشكلة التدرج المتلاشية وحللها، [71] واقترح اتصالات متبقية متكررة كحلٍ لها.[71][72] وقدّم هو و"شميدهوبر" الذاكرة قصيرة المدى المطولة (LSTM)، والتي سجلت أرقامًا قياسية في دقة العديد من مجالات التطبيقات.[73][74] غير أن هذه لم تكن بعد النسخة الحديثة من الذاكرة القصيرة المدى المطولة، والتي تطلبت بوابة النسيان، التي تم تقديمها في 1999.[75] وأصبحت فيما بعد الخيار الافتراضي لهندسة الشبكات العصبية المتكررة. خلال الفترة الممتدة من 1985 إلى 1995، مستوحاة من الميكانيكا الإحصائية، طُورَت العديد من الهياكل والأساليب على يد تيري سيجنوفسكي، وبيتر داين، وجيفري هينتون، وغيرهم، ومنها آلة بولتزمان، [76] وآلة بولتزمان المقيدة، [77] وآلة هلمهولتز، [78] وخوارزمية اليقظة والنوم.[79] وقد صُممت هذه النماذج للتعلم غير الخاضع للإشراف للنماذج التوليدية العميقة. التعلم العميقبين عامي 2009 و2012 بدأت الشبكات العصبية الاصطناعية تتفوق في مسابقات التعرف على الصور، واقتربت من مستوى الأداء البشري في مختلف المهام، لاسيما في مجالي التعرف على الأنماط والكتابة اليدوية.[80][81] وفي عام 2011 حققت شبكة عصبية تُدعى "دان نت"، [82][83] صمّمها "دان سيريسان" و"أولي ماير" و"جوناثان ماسكي" و"لوكا ماريا جامبارديلا" و"يورغن شميدهوبر"، إنجازًا بارزًا بتجاوزها الأداء البشري في مسابقة التعرف على الأنماط البصرية، متفوقة على الأساليب التقليدية بنسبة تصل إلى ثلاثة أضعاف.[36] وبعد ذلك حصدت هذه الشبكة انتصارات أخرى في مسابقات مماثلة.[84][85] كما أظهر الباحثون أن تقنية التجميع العظمى في الشبكات العصبية التلافيفية، عند تنفيذها على وحدات معالجة الرسوميات، أدت إلى تحسين الأداء بشكل ملحوظ.[86] في شهر أكتوبر من عام 2012 حققت شبكة ألكسنت، التي صممها كلٌ من أليكس كريجفسكي، وإيليا سوتسكيفر وجيفري هينتون، [87] فوزًا ساحقًا في مسابقة "إيمج نت" واسعة النطاق، متفوقة بشكل كبير على أساليب التعلم الآلي التقليدية. وشملت التطورات اللاحقة تحسينات تدريجية على الشبكة، مثل شبكة VGG-16 التي صممها كارين سيمونيان وأندرو زيسرمان، [88] وشبكة "إنسبشن 3" التي طورتها شركة جوجل.[89] في 2012 طور كلٌ من أندرو نج وجيف دين شبكة عصبية صناعية استطاعت التعرف على مفاهيم معقدة، كالأشجار والقطط، وذلك بمجرد عرض كميات هائلة من الصور عليها دون الحاجة إلى تدريبها بشكل مباشر على هذه المفاهيم.[90] وقد أدى هذا التقدم، إلى جانب التطور الكبير في قوة الحواسيب، وخاصة وحدات معالجة الرسوميات، والحوسبة الموزعة، إلى استخدام شبكات عصبية أكبر وأعقد، لاسيما في مجال معالجة الصور والرؤية الحاسوبية. وقد أُطلق على هذا المجال الجديد اسم "التعلم العميق".[91] قُدمت "دالة الأساس الشعاعي"، و"شبكات التموج" عام 2013 وسرعان ما ثبت تفوق هذه الشبكات على غيرها في قدرتها على التقريب، مما أدى إلى تطبيقها في مجالات التعرف غير الخطي والتصنيف.[92] برزت الشبكات الخصومية التوليدية (GANs) كأداة قوية في مجال النمذجة التوليدية خلال العقد الماضي، حيث حققت قفزات نوعية في مجال توليد الصور والفيديوهات وغيرها من البيانات. يعود الفضل في طرح هذه الفكرة إلى يورغن شميدهوبر عام 1991 تحت مسمى "الفضول الاصطناعي"، إلا أن إيان جودفيلو وزملاؤه هما من صاغوها بشكلها الحالي وتطويراها بشكل كبير عام 2014.[93] تعتمد آلية عمل الشبكات الخصومية التوليدية على تنافس مستمر بين شبكتين عصبيتين: شبكة توليدية وشبكة تمييزية. تعمل الشبكة التوليدية على إنشاء بيانات جديدة تحاكي البيانات الحقيقية، بينما تسعى الشبكة التمييزية إلى التمييز بين البيانات الحقيقية والوهمية التي أنشأتها الشبكة التوليدية. هذا التنافس المستمر يدفع كلا الشبكتين إلى التحسن المستمر، مما يؤدي إلى توليد نماذج أكثر واقعية.[94][95] شهدت الشبكات الخصومية التوليدية تطورات ملحوظة خلال السنوات الأخيرة، حيث حققت جودة صور ممتازة بفضل نماذج مثل "ستايل جان" التي طورتها شركة إنفيديا عام 2018، [96] والتي استندت في تصميمها على "Progressive GAN" الذي طرحه :ترو كاراس" وزملاؤه.[97] تتميز هذه النماذج بقدرتها على توليد صور عالية الدقة والواقعية، حيث تبدأ بإنشاء صور بدقة منخفضة ثم تعمل على تطويرها تدريجيًا حتى تصل إلى الدقة المطلوبة. حققت الشبكات الخصومية التوليدية شهرة واسعة واستخدامات متنوعة، لا سيما في مجال توليد الصور، مما أثار نقاشات حول الأخلاقيات المرتبطة بصور الفوتوغرافية المزيفة.[98] ومع ذلك، فقد شهدت السنوات الأخيرة بروز نماذج جديدة مثل نماذج الانتشار التي ظهرت عام 2015، [99] والتي تفوقت على الشبكات الخصومية التوليدية في بعض المجالات. ومن الأمثلة البارزة على هذه النماذج نموذجي دال-إي وستيبل ديفيوجن. في 2014 كان أحدث ما انتهت إليه الأبحاث العلمية في حقل التدريب هو ما يُعرف بـ "الشبكات العصبية العميقة جدًا"، والتي تتألف من عشرين إلى ثلاثين طبقة.[100] وقد أدى تراكم هذه الطبقات العديدة إلى تدهور حاد في دقة التدريب، [101] وهي ظاهرة عُرفت بـ "مشكلة التدهور".[102] وفي العام التالي طُورت تقنيتان لتدريب هذه الشبكات العميقة جدًا: الشبكة السريعة التي نُشرت في مايو من ذلك العام، [103] والشبكة العصبية المتبقية (ResNet) في ديسمبر من العام نفسه.[104][105] وتتصرف شبكة ResNet كشبكة سريعة ذات بوابة مفتوحة. في العقد الثاني من القرن الحادي والعشرين، شهد نموذج التسلسل تطورًا ملحوظًا بإضافة آليات الانتباه إليه، الأمر الذي أسفر عن ظهور البنية المحولية الحديثة عام 2017، كما ورد في الورقة البحثية المعنونة "الانتباه كل ما تحتاج إليه".[106] تتطلب هذه البنية وقتًا حسابيًا يتناسب طرديًا مع مربع حجم نافذة السياق. وقد أظهر وسيط الوزن السريع ليورغن شميدهوبر (1992) أن الوقت الحسابي يتناسب طرديًا مع الحجم،[107] كما ثبت لاحقًا أنه يعادل المحول الخطي غير المعياري.[8][108][109] باتت المحولات، بفضل هذه المزايا، النموذج المفضل في مجال معالجة اللغة الطبيعية.[110] وتعتمد عليها العديد من النماذج اللغوية الكبيرة الحديثة مثل شات جي بي تي، وجي بي تي-4، وبيرت. وصف عام لآلية عمل العصبون الاصطناعي بشكل عام يمكننا أن نقول أن كل شبكة عصبية ترتب بشكل طبقات من الخلايا الاصطناعية: طبقة داخلية وطبقة خارجية وطبقات بينهم أو مخفية تتواجد بين طبقتي الدخل وطبقة الخارج. كل خلية في إحدى هذه الطبقات يتصل بكافة العصبونات الموجودة في الطبقة التي تليه وكافة العصبونات في الطبقة التي تسبقه. حينما فكروا في البداية وجدوا أن الخلايا العصبية تقوم بعملية جمع الإشارات بمعني أنه توجد وصلتين لخلية عصبية مثلا وكل وصلة عليها إشارة تكون النتيجة هي محصلة الإشارات بالجمع العادي ومن ثم وجدوا أن كل عصبون يستطيع أن يقوم بعمل تكبير أو تصغير فتم إضافة عامل اسمه (Weighting Factor) بمعني أنه إذا كان هناك خلية مثلا ولها مدخلان فيتم ضرب الإشارة الأولى في المعامل الخاص بالعصبون هذا وكذا للمدخل الثاني ومن ثم يتم جمعهم وعلي ذلك تم بناء النظام الهندسي للخلايا الصناعية مع الأخذ في الاعتبار أنه ليس صحيحًا 100% بالنسبة للخلايا العصبية البيولوجية كما سيوضح لاحقا. طريقة معالجة المعلوماتكل اتصال بين عصبون وآخر يتميز بارتباطه بقيمة تدعى الوزن (Weighting) وهي تشكل مدى أهمية الارتباط بين هذين العنصرين، يقوم العصبون بضرب كل قيمة دخل واردة من عصبونات الطبقة السابقة بأوزان الاتصالات مع هذه العصبونات، من ثم جمع نواتج الضرب جميعًا، ثم إخضاع النتيجة لتابع تحويل يختلف حسب نوع العصبون، ناتج تابع التحويل يعتبر خرج العصبون الذي ينقل إلى عصبونات الطبقة اللاحقة. اختلاف مع الخلايا العصبية البيولوجيةالخلايا العصبية البيولوجية هي أعقد كثيرًا فيوجد مثلا ثلاثة أنواع للخلايا إما خلايا متواجدة داخل مكان واحد (Local Network Cell) وفي الغالب تكون مستقبلة excitatory أو محدثة inhibitory للإشارة Spike أو خلايا اتصال المدى الطويل (long Range connection) وهي خلايا تربط بين أماكن مختلفة من المخ وفي الغالب تكون مستقبلة أو خلايا حساب المجموع. يوجد شيء اسمه Dendrite أو العصبون وهذا في النموذج الهندسي عبارة عن سلكة ليس لها تأثير على الإشارة الداخلة للخلية لكن في الحقيقة فإن ذلك الجزء تعتبر مجموعة من الدوائر الإلكترونية القادرة علي إحداث الإشارة ذاتيًّا وهي تعامل معاملة المكثفات والملفات Active Component كما أنه وجد أن هذة العصبونات لها تأثير علي بعض فمثلا إذا تواجدت العصبونات بجانب بعض فتجمع الإشارة بجمع غير خطي nonlinear أما إذا كان العصبونات بعيدة عن بعض فتجمع جمع خطي عادي. الخلايا العصبية البيولوجية قادرة علي تغيير معاملات العصبونات Plasticity وهذا معناه أنها قادرة علي تغيير تشكيلها لمناسبة أقصي مجهود مطلوب بأقل الوصلات. وتقوم بعملية التغيير هذه بطريقتين إما طريقة اسمها Long Term Plasticity وهذا معناه تغيير معاملات العصبونات وذلك أيضًا معناه تغيير وظيفة الخلايا الصناعية وهذا معروف فمثلا خلايا النظر في الكفيف تغير وظيفتها بعد زمن معين من عدم العمل إلى وظيفة خلايا سمعية وذلك يتم عن طريق تغيير المعاملات والطريقة الأخرى هي Short Term Plasticity وهذا معناه أن الخلايا العصبية قادرة علي تغيير حجم الإشارة الخارجه منها حسب الوقت والظروف بمعني أنه في بعض الأحيان يكون الخارج منها مكبرًا بصورة كبيرة وبعض الأحيان الأخرى يكون الخارج مصغرً ولا زالت الأسباب غير معروفه حتي الآن. البنيةتعتبر الشبكات العصبونية الاصطناعية، أو اختصارًا الشبكات العصبونية، مجموعة متوازية من وحدات المعالجة الصغيرة والبسيطة التي تدعى بالعقد أو العصبونات، في حين تكتسب الاتصالات البينية بين مختلف هذه الوحدات أهمية خاصة وتقوم بدور كبير في خلق ذكاء الشبكة، لكن على العموم ورغم أن الفكرة أساسًا مستوحاة من آلية عمل العصبونات الدماغية فلا يجب أن نخلط كثيرًا أو نشابه بين الدماغ والشبكات العصبونية فالشبكات العصبونية أصغر وأبسط من العصبونات البيولوجية وقد تكون مجرد وحدات افتراضية تنشؤها برامج الحاسب، كما أن آلية عمل العصبونات الاصطناعية تقتبس بعض ميزات العصبون البيولوجي ولا تشابهه تمامًا، بالمقابل أضيفت العديد من الميزات وتقنيات المعالجة إلى العصبونات الاصطناعية بناء على أفكار رياضية أو هندسية، وهذه الإضافات أو أساليب العمل الجديدة (بعضها مقتبس من الإحصاء أو من نظرية المعلومات) لا ترتبط بالعصبونات البيولوجية أبدًا. بالمقابل تبدي الشبكات العصبونية ميزة مهمة كان الدماغ يتفرد بها ألا وهي التعلم وهذا ما يمنح هذه الشبكات أهمية خاصة في الذكاء الصناعي. اقرأ أيضا: عصبون اصطناعي، بيرسيبترون نماذج الشبكات العصبونيةتم استيحاء آلية عمل العصبون الاصطناعي من عصبونات الدماغ: ففي العصبونات الحيوية، يمكن أن ننسب لكل مشبك اتصالًا قادمًا incoming synapse (أي مشابك التفرعات العصبية dendrite) قيمة تدعى وزن المشبك weight تساعد هذه القيمة في نمذجة المشبك (عن طريق تحديد قيمته وأهميته) فالوزن يحدد قوة هذا المشبك وأثره في العصبون. يضرب وزن كل مشبك بالدخل القادم، ومن ثم تجمع نواتج الضرب لكل المشابك القادمة. عادة ما تكون العصبونات البيولوجية تابعة لقاعدة قيمة العتبة 'threshold value' فإذا كان المجموع الموزون weighted Sum لقيم الدخل أكبر من قيمة معينة تدعى العتبة threshold، يضطرم العصبون أو لِنَقُل أنه يتفعّل مرسلا إشارة كهربائية تدعى كمون الفعل على طول المحور العصبي axon ومن ثم تصل هذه الإشارة عن طريق تفرعات المحور إلى كل المشابك الخارجة outgoing synapses التي تتصل بعصبونات أخرى في الدماغ الشبكات العصبونية النموذجية تحاول أن تقلد هذا السلوك، فكل عقدة عصبونية تتلقى مجموعة من المدخلات عن طريق اتصالاتها بالعصبونات القبلية وكل عقدة لها تابع تفعيل activation function أو تابع تحويل transfer function، يحدد للعقدة متى وكيف تعمل أي لحظة وقيمة الخرج التي يجب أن تعطيها تمامًا كما العصبون البيولوجي. أبسط توابع التحويل هو تابع قيمة العتبة الذي يعمل العصبون على أساسه: معطيا قيمة 1 إذا كان المجموع الموزون لقيم الداخلي أكبر من قيمة معينة تدعى العتبة و 0 إذا كان المجموع الموزون أقل من العتبة. لكن توابع التحويل يمكن لها أن تأخذ أشكالا أخرى أكثر تعقيدًا أهمها تابع السيغمويد (التابع الأسي), ولا تخلو شبكة من بعض عقد عصبية تملك تابع تحويل أسي، بشكل عام معظم توابع التحويل تحول قيمة المجموع الموزون لقيم الدخل إلى قيمة وحيدة محصورة في المجال [0-1]. واحدة من أهم أنواع الشبكات العصبونية: الشبكة العصبونية أمامية التغذية وهي مجموعة عقد عصبونية مرتبة بشكل طبقات. ترتبط هذه العصبونات مع بعضها عادة بحيث يرتبط كل عصبون في طبقة ما بجميع العصبونات في الطبقة التالية (لا ترتبط عصبونات نفس الطبقة مع بعضها). الشكل النموذجي لهذه الشبكات هو ثلاث طبقات عصبونية على الأقل تدعى (طبقة دخل input layer، طبقة مخفية hidden layer، طبقة خرج output layer) طبقة الدخل لا تقوم بأي عملية معالجة فهي ببساطة مكان تغذية الشبكة بشعاع البيانات، تقوم طبقة الدخل بعد ذلك بتغذية (نقل المعلومات) الطبقة المخفية ومن ثم تقوم الطبقة المخفية بتغذية طبقة الخرج. المعالجة الفعلية للبيانات Data تتم في الطبقة المخفية وطبقة الخرج أساسًا. عندما يكون هناك عدد كاف من العصبونات، تكون الشبكة قادرة على التدرب training للقيام بأشياء مفيدة بالاستعانة بخوارزميات التدريب training algorithm، تعتبر الشبكات أمامية التغذية مهمة جدًا خاصة في استخدامات التصنيف الذكي والتمييز الذكي لبيانات غير مألوفة مسبقًا. الاستعمالات

الأسس البيولوجيةتعتمد الشبكات العصبية على تقليد عمل أعصاب الدماغ. أنواع الشبكات العصبونية

تعليم الشبكات العصبيةالشباكات العصبونية لا تبرمج بل إنها تقوم بالتعلم وهنالك العديد من خوارزميات التعلم منها Back Propagation algorithm (وهي خوارزمية تعتمد انتشار الأخطاء من الخلف إلى الأمام لضبط أوزان الشبكة) وطريقة هيب Hebb Rule. الآفاق

مراجع

|